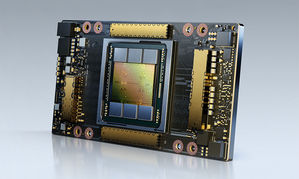

NVIDIA (辉达) 宣布推出 NVIDIA A100 80GB GPU,其记忆体容量较前一代多出一倍,将为次世代的 AI 与科学研究提供倍数的效能。

|

| /news/2020/11/17/2002047630S.jpg |

NVIDIA指出, A100 搭载 HBM2e 技术,将 A100 40GB GPU 的高频宽记忆体容量加倍至 80GB,提供每秒超过 2 terabytes (TB) 的记忆体频宽。

NVIDIA 深度学习应用研究部门??总裁 Bryan Catanzaro 表示,若想获得高效能运算 (HPC) 与人工智慧 (AI) 最顶尖的研究成果,就必须建立极庞大的模型,而这也代表将会需要比过去更多的记忆体容量和传输频宽。A100 80GB GPU 提供比前一代 GPU 多一倍的记忆体容量,让研究人员能克服全球最重要的科学与大数据研究难题。

在 AI 训练方面,例如 DLRM 这类含有大量表格以记载数十亿名用户及数十亿项产品的推荐系统模型,由於 A100 80GB 能提供 3 倍的加速效果,因此企业能快速重新训练这些模型,以提供高精准度的建议。

此外,A100 80GB 还能训练最庞大的模型,透过套用更多叁数,导入到配备单一 HGX 的伺服器,例如GPT-2 ━━ 一个运用自然语言处理模型来执行超越人类的文字生成功能。如此一来就不再需要耗费大量时间建置资料或模型平行处理架构,而且这类技术在跨多个节点运行时速度过慢。

凭藉本身具备的多执行个体GPU (MIG) 技术,A100 可切分成7个GPU执行个体,而单一个体配有 10GB 的记忆体,构成安全无虞的硬体分隔区,并能为各种规模较小的作业负载提供最高的 GPU 资源使用率。对於像 RNN-T 这类自动语音辨识模型的 AI 推论,光靠一个 A100 80GB MIG 执行个体就能处理更大的批量,在生成环境中的推论吞吐量提高 1.25 倍。

在 TB 规模的零售业大数据分析基准方面,A100 80GB 能产生最高 2 倍的效能,故能针对庞大的资料集快速获得洞察,而企业则能透过这些随时更新的资料即时做出关键决策。

在诸如气象预报及量子化学等科学应用方面,A100 80GB 能提供强大的加速效果。例如像 Quantum Espresso 这款材料模拟软体,在单节点 A100 80GB 系统运行可达到接近 2 倍的资料产出量提升。

NVIDIA A100 80GB GPU 现已搭载於 NVIDIA DGXT A100 和NVIDIA DGX Station A100 系统,预计在本季开始出货。包括Atos、戴尔科技 (Dell Technologies)、富士通 (Fujitsu)、技嘉 (GIGABYTE)、慧与科技 (Hewlett Packard Enterprise)、浪潮 (Inspur)、联想 (Lenovo)、广达 (Quanta) 和美超微 (Supermicro) 等系统大厂,预计於 2021 上半年开始提供整合四个或八个 A100 80GB GPU 基板的 HGX A100 。