NVIDIA(辉达)今日宣布推出采用NVIDIA Hopper架构的新一代加速运算平台,效能较上一代平台呈指数级成长。这个以美国电脑科学家先驱Grace Hopper命名的全新架构,将接替两年前推出的NVIDIA Ampere架构。

|

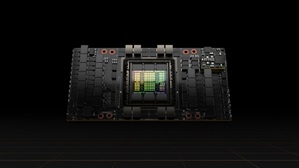

| NVIDIA H100为每个资料中心提供突破性的效能、可扩展性与安全性 |

NVIDIA亦宣布推出首款采用Hopper架构的GPU产品NVIDIA H100,这款GPU封装了800亿个电晶体,是全球最大且效能最强大的加速器,具突破性的功能,例如革命性的Transformer Engine及具高度扩展性的NVLink互连技术,可用於推动极大规模的AI语言模型、深度推荐系统、基因组学和复杂的数位孪生等领域的发展。

NVIDIA创办人暨执行长黄仁勋表示:「资料中心将成为AI工厂,用来处理海量资料并从中提炼出宝贵的智慧。NVIDIA H100是全球AI基础设施的引擎,让企业得以加速推动各项AI业务的进展。」

NVIDIA H100 GPU为加速大规模AI及高效能运算树立了新标准,并带来六项突破性创新:

全球最先进的晶片:H100拥有800亿个电晶体,采用台积电4N制程、专为满足NVIDIA加速运算需求而设计,在加速AI、高效能运算、记忆体频宽、互连和通讯方面具有重大进展,包括每秒近5TB的外部连接速度。

H100是首款支援PCIe Gen5及首款使用HBM3的GPU产品,提供每秒3TB的记忆体频宽。20个H100 GPU便足以支撑全世界的网路流量,让客户得以运行先进的推荐系统和大型语言模型,即时使用各项资料进行推论。

全新Transformer Engine:Transformer已是自然语言处理的首选标准模型,是史上最重要的深度学习模型之一。相较於前一代产品,H100加速器的Transformer Engine能够将这些网路的速度提高六倍,又不失其精度。

第二代安全多执行个体GPU:多执行个体GPU(Multi-Instance GPU;MIG)技术可以将一个GPU分割成七个较小、完全隔离的执行个体以处理各类工作。Hopper架构在云端环境里为每个GPU执行个体提供安全的多租户配置,将MIG的能力较前一代扩大高达七倍。

机密运算:H100是全球首款具有机密运算能力的加速器,可以在处理AI模型和客户资料时加以保护。对於医疗照护和金融服务等对隐私极为敏感的产业,在进行联邦学习时同样能运用机密运算,在共享的云端基础设施上也同样可行。

第四代NVIDIA NVLink:为加快最大型AI模型的运作速度,以NVLink搭配全新的外部NVLink交换器,将NVLink当成伺服器以外的垂直扩展网路,相较於使用NVIDIA HDR Quantum InfiniBand的前一代产品,能以超过九倍的频宽连接多达256个 H100 GPU。

DPX指令:与使用CPU相比,全新DPX指令将用於众多演算法(包括路线最隹化及基因组学)的动态规画执行速度加快高达40倍;而与使用前一代的GPU相比,速度加快了七倍。这包括为动态仓库环境中的自主机器人车队寻找最隹路线的Floyd-Warshall演算法,以及用於DNA和蛋白质分类及折叠的序列比对Smith-Waterman演算法。

H100的多项技术创新扩大了NVIDIA在AI推论和训练的领先地位,使NVIDIA能够利用巨大的AI模型做到即时和沉浸式应用。

H100让聊天机器人可以使用全球最强大的单体transformer语言模型Megatron 530B,其传输量超过前一代产品达30倍,同时满足即时对话式AI所需的次秒级延迟。H100同时让研究人员和开发人员能够训练像是Mixture of Experts这类大规模模型,包含3,950亿个叁数,能将速度提高达九倍,将训练时间从过去所需的数周减少到数日便能完成。

NVIDIA H100可以部署在各类型的资料中心内,包括企业内部、云端、混合云和边缘。预计今年稍晚透过全球各大云端服务供应商及电脑制造商供货,也可以直接向NVIDIA购买。

NVIDIA第四代DGX系统DGX H100搭载八个H100 GPU,可在全新FP8精度下提供32 petaflops的AI运算表现,这个规模足以满足大型语言模型、推荐系统、医疗研究及气候科学的大规模运算需求。

透过第四代NVLink技术连接DGX H100系统中的每个GPU,能提供每秒900GB的连接速度,高出前一代产品1.5倍。NVSwitch技术让八个H100 GPU能透过NVLink连接。一台外部NVLink交换器可以连接新一代NVIDIA DGX SuperPOD超级电脑中多达32个DGX H100节点。

Hopper已经获得各大云端服务供应商的支持,包括阿里云、Amazon Web Services(AWS)、百度智能云、Google Cloud、Microsoft Azure、Oracle Cloud和腾讯云,这些业者计画将提供基於H100的执行个体。

全球一级系统制造商预计将推出多款搭载H100加速器的伺服器产品,包括源讯(Atos)、BOXX Technologies、思科(Cisco)、戴尔科技(Dell Technologies)、富士通(Fujitsu)、技嘉(GIGABYTE)、新华三(H3C)、慧与科技(Hewlett Packard Enterprise)、浪潮(Inspur)、联想(Lenovo)、Nettrix与美超微(Supermicro)。

H100将有SXM和PCIe两种规格,以满足各种伺服器的设计要求。同时也将推出一款融合加速器,将H100 GPU搭配NVIDIA ConnectX-7 400Gb/s InfiniBand及Ethernet SmartNIC。

H100 SXM规格将用於HGX H100伺服器主机板上,提供四路和八路配置,供企业在一台伺服器和多台伺服器上的应用程式扩大到多个GPU上。搭载HGX H100的伺服器为AI训练和推论、资料分析和高效能运算应用程式提供最隹运算表现。

H100 PCIe规格使用NVLink来连接两个GPU,提供较PCIe 5.0还要高出七倍的频宽,为在主流企业伺服器上运行的应用程式提供出色效能。PCIe的规格尺寸让此产品能够轻松地被纳入现有的资料中心基础设施中。

全新的融合加速器H100 CNX则是将H100搭配ConnectX-7 SmartNIC,为企业资料中心的多节点AI训练,以及边缘的5G讯号处理等I/O密集型应用程式提供突破性的效能。

采用NVIDIA Hopper架构的GPU还能搭配NVIDIA Grace CPU,後者具备超高速NVLink-C2C互连技术,与PCIe 5.0相比,CPU与GPU之间的资料传输速度提高七倍以上。这样的组合诞生出Grace Hopper超级晶片,用於巨大规模高效能运算及AI应用程式的整合模组。

NVIDIA提供强大的软体工具来支援H100 GPU,开发人员与企业便能建立及加速AI与高效能运算各类应用程式,包括针对语音、推荐系统和超大规模推论等作业负载所推出的NVIDIA AI软体套件重大更新。

NVIDIA还发布了超过60项CUDA-X函式库、工具和技术更新,以加快量子运算、6G网路研究、网路安全、基因组学和药物开发等方面的进展。

NVIDIA H100将於第三季开始供货。