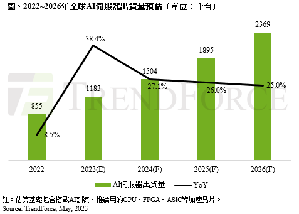

AI伺服器及AI晶片需求同步看漲,TrendForce今(29)日預估2023年AI伺服器(包含搭載GPU、FPGA、ASIC等)出貨量近120萬台,年增38.4%,占整體伺服器出貨量近9%,至2026年將占15%,同步上修2022~2026年AI伺服器出貨量年複合成長率至22%。而AI晶片2023年出貨量將成長46%。

|

| /news/2023/05/29/1613088280S.png |

TrendForce表示,NVIDIA GPU為AI伺服器市場搭載主流,市占率約60~70%,其次為雲端業者自主研發的AISC晶片,市占率逾20%。觀察NVIDIA市占率高的主要原因有3:

1. 目前不論美系或中系雲端服務業者(CSP),除了採購原有的NVIDIA的A100、A800之外,下半年需求也將陸續導入新機種H100與H800,平均銷售單價約為A100與A800的2~2.5倍,加上NVIDIA同時積極銷售自家相關整機解決方案;

2. 且高階GPU A100及H100的高獲利模式也是關鍵,由於旗下產品在AI伺服器市場已擁有主導權的優勢,依TrendForce研究H100本身的價差,也依據買方採購規模,將會產生近5,000美元的差異;

3. 下半年ChatBOT及AI運算風潮將持續滲透至各種專業領域,如雲端/電商服務、智慧製造、金融保險、智慧醫療及智慧駕駛輔助等開發市場,同步帶動每台搭配4~8張GPU的雲端AI,以及每台搭載2~4張GPU的邊緣AI伺服器應用需求漸增,預估今年搭載A100及H100的AI伺服器出貨量年增率逾5成。

此外,從高階GPU搭載的HBM來看,NVIDIA高階GPU H100、A100主採HBM2e、HBM3。以今年H100 GPU來說,搭載HBM3技術規格,其中傳輸速度也較HBM2e快,可提升整體AI伺服器系統運算效能。隨著高階GPU如NVIDIA的A100、H100;AMD的MI200、MI300,以及Google自研的TPU等需求皆逐步提升下,TrendForce預估2023年HBM需求量將年增58%,2024年有望再成長約30%。