机器人模仿学习 (Imitation learning; IL) 技术是透过观察人类示范来训练机器人,但受限於数据收集的规模和效率。传统方法依赖昂贵且复杂的硬体设备,难以普及。为此,苹果与科罗拉多大学波德分校的研究团队开发了ARMADA系统,利用Apple Vision Pro实现更直观、高效的机器人训练。

|

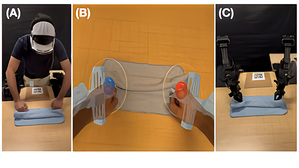

| (A) 戴着 Apple Vision Pro 的示范者直接用手来收集数据。(B) Vision Pro透过AR将机器人即时执行的动作叠加在使用者手上。(C) 直接在实体机器人上重播。(source:marktechpost) |

传统的模仿学习系统通常需要人类操作机器人,虽然有效但面临许多限制。这些系统仰赖透过手套、动作捕捉和虚拟实境 (VR) 装置进行远程操作,需要复杂的设置和低延迟控制??路。此外,它们还依赖实体机器人和特殊用途硬体,难以扩展应用。

尽管机器人可以使用这些方法收集的专家数据执行诸如??入电池或系鞋带之类的任务,但对特殊设备的需求使得这些方法在大规模或更广泛的应用中不切实际。

为了克服这些挑战,来自苹果公司和科罗拉多大学波德分校的研究团队提出了一种名为 ARMADA 的创新系统。该系统将 Apple Vision Pro 头戴式装置与外部机器人控制系统结合,利用 ROS 和 WebSockets 的组合实现设备间的通讯。

这种设置让系统具备随??即用的特性,并且只需替换 3D 模型档案和头戴式装置的数据格式,即可灵活适用於各种机器人平台,例如 Franka 和 UR5。ARMADA 应用程式负责处理机器人视觉化、数据储存和使用者介面,接收机器人连结的转换框架、捕捉来自摄影机的影像帧,以及追踪人体骨骼数据以进行处理。机器人节点则负责管理控制、数据储存和约束计算,将骨骼数据转换为机器人指令,并检测工作空间违规、奇异点和速度问题,以提供即时反??。

透过 visionOS 2.0 中的 ARKit,系统可以追踪人类手腕和手指的位置,并利用反向运动学来计算关节位置和控制基於手指间距的夹爪,从而使机器人的动作与人类的手部动作保持一致。此外,系统会透过颜色变化、虚拟边界或萤幕文字来视觉化奇异点、工作空间限制和速度违规等约束条件。

研究人员使用 ARMADA 系统执行了三项任务:从盒子中取出纸巾、将玩具放入纸箱以及用双手擦拭桌子。评估结果显示,反??视觉化显着提高了「取出纸巾」、「整理杂物」和「双手擦拭」等任务的重播成功率,与没有反??相比,提升幅度高达 85%。

总而言之,ARMADA 系统透过使用扩增实境提供即时反??来提高数据质量和与实体机器人的兼容性,解决了机器人模仿学习中可扩展数据收集的挑战。研究结果显示了反??对於将无机器人示范与真实机器人运动学对齐的重要性。尽管该研究专注於较简单的任务,但未来的研究可以探索更复杂的任务并改进技术。该系统可以作为未来机器人研究的基准,特别是在透过视觉观察进行模仿学习来训练机器人控制策略方面。