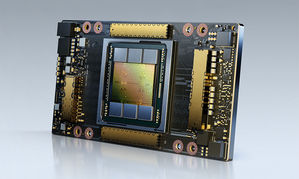

NVIDIA (ијқйҒ”) е®ЈеёғжҺЁеҮә NVIDIA A100 80GB GPUпјҢе…¶иЁҳжҶ¶й«”е®№йҮҸијғеүҚдёҖд»ЈеӨҡеҮәдёҖеҖҚпјҢе°ҮзӮәж¬Ўдё–д»Јзҡ„ AI иҲҮ科еӯёз ”究жҸҗдҫӣеҖҚж•ёзҡ„ж•ҲиғҪгҖӮ

|

| /news/2020/11/17/2002047630S.jpg |

NVIDIAжҢҮеҮәпјҢ A100 жҗӯијү HBM2e жҠҖиЎ“пјҢе°Ү A100 40GB GPU зҡ„й«ҳй »еҜ¬иЁҳжҶ¶й«”е®№йҮҸеҠ еҖҚиҮі 80GBпјҢжҸҗдҫӣжҜҸз§’и¶…йҒҺ 2 terabytes (TB) зҡ„иЁҳжҶ¶й«”й »еҜ¬гҖӮ

NVIDIA ж·ұеәҰеӯёзҝ’жҮүз”Ёз ”з©¶йғЁй–ҖеүҜзёҪиЈҒ Bryan Catanzaro иЎЁзӨәпјҢиӢҘжғізҚІеҫ—й«ҳж•ҲиғҪйҒӢз®— (HPC) иҲҮдәәе·Ҙжҷәж…§ (AI) жңҖй Ӯе°–зҡ„з ”з©¶жҲҗжһңпјҢе°ұеҝ…й Ҳе»әз«ӢжҘөйҫҗеӨ§зҡ„жЁЎеһӢпјҢиҖҢйҖҷд№ҹд»ЈиЎЁе°ҮжңғйңҖиҰҒжҜ”йҒҺеҺ»жӣҙеӨҡзҡ„иЁҳжҶ¶й«”е®№йҮҸе’ҢеӮіијёй »еҜ¬гҖӮA100 80GB GPU жҸҗдҫӣжҜ”еүҚдёҖд»Ј GPU еӨҡдёҖеҖҚзҡ„иЁҳжҶ¶й«”е®№йҮҸпјҢи®“з ”з©¶дәәе“ЎиғҪе…ӢжңҚе…ЁзҗғжңҖйҮҚиҰҒзҡ„科еӯёиҲҮеӨ§ж•ёж“ҡз ”з©¶йӣЈйЎҢгҖӮ

еңЁ AI иЁ“з·ҙж–№йқўпјҢдҫӢеҰӮ DLRM йҖҷйЎһеҗ«жңүеӨ§йҮҸиЎЁж јд»ҘиЁҳијүж•ёеҚҒе„„еҗҚз”ЁжҲ¶еҸҠж•ёеҚҒе„„й …з”ўе“Ғзҡ„жҺЁи–Ұзі»зөұжЁЎеһӢпјҢз”ұж–ј A100 80GB иғҪжҸҗдҫӣ 3 еҖҚзҡ„еҠ йҖҹж•ҲжһңпјҢеӣ жӯӨдјҒжҘӯиғҪеҝ«йҖҹйҮҚж–°иЁ“з·ҙйҖҷдәӣжЁЎеһӢпјҢд»ҘжҸҗдҫӣй«ҳзІҫжә–еәҰзҡ„е»әиӯ°гҖӮ

жӯӨеӨ–пјҢA100 80GB йӮ„иғҪиЁ“з·ҙжңҖйҫҗеӨ§зҡ„жЁЎеһӢпјҢйҖҸйҒҺеҘ—з”ЁжӣҙеӨҡеҸғж•ёпјҢе°Һе…ҘеҲ°й…ҚеӮҷе–®дёҖ HGX зҡ„дјәжңҚеҷЁпјҢдҫӢеҰӮGPT-2 в”Җв”Җ дёҖеҖӢйҒӢз”ЁиҮӘ然иӘһиЁҖиҷ•зҗҶжЁЎеһӢдҫҶеҹ·иЎҢи¶…и¶ҠдәәйЎһзҡ„ж–Үеӯ—з”ҹжҲҗеҠҹиғҪгҖӮеҰӮжӯӨдёҖдҫҶе°ұдёҚеҶҚйңҖиҰҒиҖ—иІ»еӨ§йҮҸжҷӮй–“е»әзҪ®иіҮж–ҷжҲ–жЁЎеһӢе№іиЎҢиҷ•зҗҶжһ¶ж§ӢпјҢиҖҢдё”йҖҷйЎһжҠҖиЎ“еңЁи·ЁеӨҡеҖӢзҜҖй»һйҒӢиЎҢжҷӮйҖҹеәҰйҒҺж…ўгҖӮ

жҶ‘и—үжң¬иә«е…·еӮҷзҡ„еӨҡеҹ·иЎҢеҖӢй«”GPU (MIG) жҠҖиЎ“пјҢA100 еҸҜеҲҮеҲҶжҲҗ7еҖӢGPUеҹ·иЎҢеҖӢй«”пјҢиҖҢе–®дёҖеҖӢй«”й…Қжңү 10GB зҡ„иЁҳжҶ¶й«”пјҢж§ӢжҲҗе®үе…Ёз„Ўиҷһзҡ„зЎ¬й«”еҲҶйҡ”еҚҖпјҢдёҰиғҪзӮәеҗ„зЁ®иҰҸжЁЎијғе°Ҹзҡ„дҪңжҘӯиІ ијүжҸҗдҫӣжңҖй«ҳзҡ„ GPU иіҮжәҗдҪҝз”ЁзҺҮгҖӮе°Қж–јеғҸ RNN-T йҖҷйЎһиҮӘеӢ•иӘһйҹіиҫЁиӯҳжЁЎеһӢзҡ„ AI жҺЁи«–пјҢе…үйқ дёҖеҖӢ A100 80GB MIG еҹ·иЎҢеҖӢй«”е°ұиғҪиҷ•зҗҶжӣҙеӨ§зҡ„жү№йҮҸпјҢеңЁз”ҹжҲҗз’°еўғдёӯзҡ„жҺЁи«–еҗһеҗҗйҮҸжҸҗй«ҳ 1.25 еҖҚгҖӮ

еңЁ TB иҰҸжЁЎзҡ„йӣ¶е”®жҘӯеӨ§ж•ёж“ҡеҲҶжһҗеҹәжә–ж–№йқўпјҢA100 80GB иғҪз”ўз”ҹжңҖй«ҳ 2 еҖҚзҡ„ж•ҲиғҪпјҢж•…иғҪйҮқе°ҚйҫҗеӨ§зҡ„иіҮж–ҷйӣҶеҝ«йҖҹзҚІеҫ—жҙһеҜҹпјҢиҖҢдјҒжҘӯеүҮиғҪйҖҸйҒҺйҖҷдәӣйҡЁжҷӮжӣҙж–°зҡ„иіҮж–ҷеҚіжҷӮеҒҡеҮәй—ңйҚөжұәзӯ–гҖӮ

еңЁи«ёеҰӮж°ЈиұЎй җе ұеҸҠйҮҸеӯҗеҢ–еӯёзӯү科еӯёжҮүз”Ёж–№йқўпјҢA100 80GB иғҪжҸҗдҫӣеј·еӨ§зҡ„еҠ йҖҹж•ҲжһңгҖӮдҫӢеҰӮеғҸ Quantum Espresso йҖҷж¬ҫжқҗж–ҷ模擬и»ҹй«”пјҢеңЁе–®зҜҖй»һ A100 80GB зі»зөұйҒӢиЎҢеҸҜйҒ”еҲ°жҺҘиҝ‘ 2 еҖҚзҡ„иіҮж–ҷз”ўеҮәйҮҸжҸҗеҚҮгҖӮ

NVIDIA A100 80GB GPU зҸҫе·Іжҗӯијүж–ј NVIDIA DGXT A100 е’ҢNVIDIA DGX Station A100 зі»зөұпјҢй җиЁҲеңЁжң¬еӯЈй–Ӣе§ӢеҮәиІЁгҖӮеҢ…жӢ¬AtosгҖҒжҲҙзҲҫ科жҠҖ (Dell Technologies)гҖҒеҜҢеЈ«йҖҡ (Fujitsu)гҖҒжҠҖеҳү (GIGABYTE)гҖҒж…§иҲҮ科жҠҖ (Hewlett Packard Enterprise)гҖҒжөӘжҪ® (Inspur)гҖҒиҒҜжғі (Lenovo)гҖҒе»ЈйҒ” (Quanta) е’ҢзҫҺи¶…еҫ® (Supermicro) зӯүзі»зөұеӨ§е» пјҢй җиЁҲж–ј 2021 дёҠеҚҠе№ҙй–Ӣе§ӢжҸҗдҫӣж•ҙеҗҲеӣӣеҖӢжҲ–е…«еҖӢ A100 80GB GPU еҹәжқҝзҡ„ HGX A100 гҖӮ