自動駕駛輔助系統(ADAS)具備預測並減緩駕駛失誤的功能,擴大部署車載ADAS就有可能降低交通事故致死的發生次數。然而,單一的系統難以概括所有的駕駛需求、情境與交通或天氣條件,因此新一代的高效ADAS極有可能源自多項感測技術的整合。愛美科影像處理與判讀研究團隊(Image Processing and Interpretation research group;IPI)將介紹兩項行人偵測系統的最新技術突破:雷達與影像感測器融合技術、自動化色調映射技術。

當雷達遇上影像感測器:別具巧思的融合組合

未來車輛是否能快速且準確地偵測用路人與路障,將會對降低交通事故致死的發生起到關鍵作用。不過沒有任何一個感測或感知系統可以涵蓋所有需求、情境以及交通或天氣條件。

舉例來說,攝影機在夜間或面對刺眼陽光時就難以正常運作,而雷達會受到反光的金屬物件干擾。然而,當這兩種感測器相互整合時,各自的優劣就能完美地互補,實現雷達與影像的感測器融合(radar-video sensor fusion;RVF)。

感測器融合(sensor fusion)運用多種感測訊號的輸入,得以建構出一套感知汽車周遭環境的改良式(3D)模型。利用這些資訊並借助深度學習方法,已偵測物件被區分為不同類別,例如汽車、行人、單車騎士、建築物、人行道等,而這些數據洞見就是ADAS做出智慧駕駛與防碰撞決策的基礎。

新手上路:合作式雷達與影像感測器融合

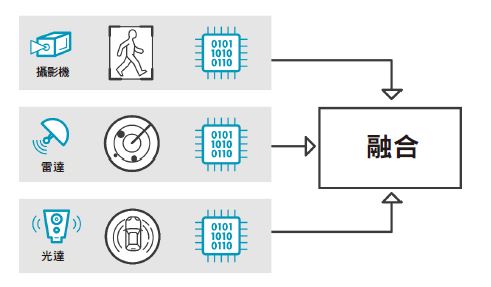

目前最熱門的感測器融合技術叫做「晚期融合(late fusion)」,感測器資料只會在不同感測器分別偵測物件,並根據各自有限蒐集而來的資料作出「決策(decision)」後,才進行融合。其主要缺點是,每個感測器會拋棄各自視為不相關的所有資料,所以就失去了很多應用感測器融合技術的潛力。實務上,這甚至可能會導致汽車撞上某個單一感測器一直偵測不到的物件。

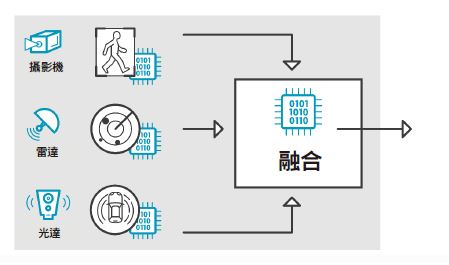

相對而言,「早期融合(early fusion)」或低階資料融合(low-level data fusion),則是將每個感測器蒐集而來的低階資料,整合在同個智慧系統以處理所有資料。但也因此需要大量的運算力及頻寬,包括從每個感測器連接到系統中央處理引擎的高頻寬鏈路。

| 圖一 : 晚期融合:感測器資料在每個獨立感測器分別偵測物件並做出結論後才進行融合。(source:imec) |

|

| 圖二 : 早期融合基於每個感測器蒐集到的所有低階資料,在得以處理所有資料的單一智慧系統進行整合。(source:imec) |

|

面對這些問題,愛美科於比利時根特大學設置的IPI研究團隊持續開發「合作式雷達與影像感測器融合(cooperative radar-video sensor fusion)」的概念,其特色在於一回饋迴路(feedback loop),不同感測器可以互相交換低階或中階資料,在彼此進行偵測處理時產生影響。例如,如果汽車的雷達系統忽然受到強烈反光,那麼車載攝影機的偵測閥值就會自動調整,以進行補償。於是本來難以偵測到的行人現在就能成功辨識,而且系統不至於變得過度敏感或面對假陽性的結果。

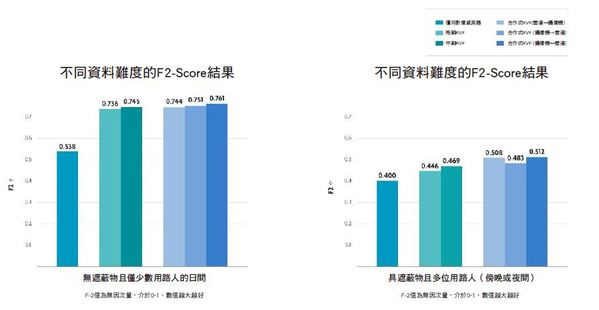

交通與天氣條件嚴峻 準確度仍高出晚期融合15%

去年IPI團隊展示了合作式感測器融合方法的研究成果,與現今常用的晚期融合相比,效能更佳,而且因為它沒有頻寬和實作的限制,也比早期融合還要容易部署。

經過混合了歐洲某市中心各種交通情境的資料集評估,該團隊成功提升追蹤行人與單車騎士的準確度,比起使用單一攝影機的系統高出20%。此外,混合式感測器融合的首次偵測速度已證實較之於競爭方案,還要快上0.25秒。

IPI團隊資深研究員David Van Hamme聲稱:「過去數月,我們持續改良這套系統,更進一步提升行人偵測的準確度,尤其是針對嚴峻的交通和天氣條件。」

他表示,當用於簡易情境,例如大白天、毫無遮蔽且不太複雜的場景,這套方法比起單純使用攝影機的系統,準確度現已提升了41%,與晚期融合相較也高出3%。

「但或許更重要的是,我們已經在其他情境中獲得進展,例如光線不足、行人位處遮蔽區域和人潮擁擠的場景等。」Van Hamme繼續補充:「畢竟這些情況都是行人偵測系統證明其存在價值的關鍵時刻。在這類高難度的情況下,合作式雷達與影像感測器融合所能帶來的好處更是令人驚豔,相較於晚期融合,準確度成長幅度高達15%。」

| 圖三 : 比較不同行人偵測方法測得的F2-Score,包含簡易情境(左圖)與嚴峻情況(右圖)。F2-Score可以客觀地測量系統準確度,權重聚焦在未命中率(假陰性)。在兩種情境中,合作式雷達與影像感測器融合的效能表現皆勝過單純使用攝影機和晚期融合的競爭方法。(source:imec) |

|

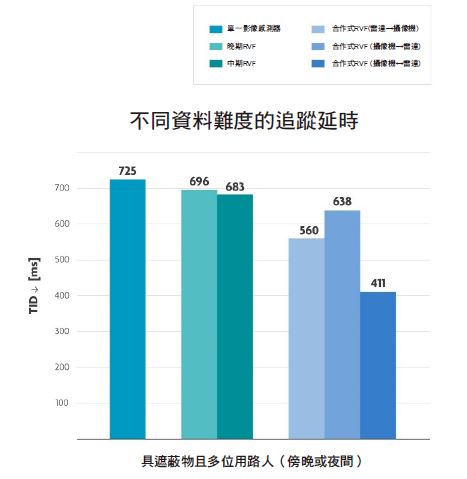

延遲表現大躍進

Van Hamme表示:「這還不是所有。談到縮短延遲(latency),或說是追蹤延時(tracking delay),我們也實現了大躍進。例如,在天氣與交通條件不佳的情況下,我們已經達到411ms的短延遲,也就是說,不論是與僅用影像感測器的系統(725ms),或是晚期融合系統(696ms)相較,都還要快上超過40%。」

| 圖四 : 經過多項標準的綜合評估,包含傍晚、夜間、受到遮蔽且多位弱勢用路人(vulnerable road user;VRU)在場的情境設定下,合作式RVF的延遲已成功降至411ms。(source:imec) |

|

追求未來的技術突破

Van Hamme說道:「在整合雷達與影像系統以偵測弱勢用路人的技術上,我們絕對是先鋒,目前我們呈現的研究成果顯示了這套方法的潛力無窮。我們相信它能成為現有行人偵測技術的強勁對手,目前常用的是更複雜、更繁瑣且造價昂貴的光達解決方案。」

他接著表示,IPI團隊也期許在這塊領域持續突破,將這套合作式RVF方法拓展到其他應用案例,例如車輛偵測就是其中之一。另一個研究重點是建構反應機智的車載系統,要能處理突發的功能缺陷或是故障。最後,還要改良那些隱於車載系統之中的神經網路,該團隊也想多加探索實現一些技術突破。

Van Hamme總結:「目前AI引擎有個具體缺點,就是他們接受訓練是為了盡可能地偵測到更多的弱勢用路人,但我們團隊認為,這未必是降低交通事故致死發生的最好方法。一位剛在駕駛車輛前方50公尺過完馬路的行人,真的有必要確實偵測嗎?我們認為其實不必,反而最好能將這些運算資源用在其他地方。」

把這個想法套用到某個神經網路上,確立偵測的優先考量落在汽車預測路徑上的弱勢用路人,這也是該團隊意欲偕同商業夥伴開發的研究項目之一。

自動化色調映射技術 部建於車載影像系統

如上所述,影像技術是目前ADAS系統的重要基石,但也有其不足之處。以基於可見光的攝影機為例,它在夜間或嚴酷的天氣狀況下,例如大雨、下雪等,運作效能就會變得很差。除此之外,一般相機的特點是有限動態範圍,這通常會在光源不足的場景造成對比度流失的問題。

當然,這些效能限制有的可以透過配備高動態範圍(HDR)相機來彌補,但HDR相機會讓訊號處理複雜化,因為高位元率的視訊串流會不斷出現,很可能造成ADAS內部的AI引擎負載過重。

整合這兩種感測器的優勢,IPI研究人員開發出了自動化色調映射技術(automatic tone mapping),這是一種將高位元率的HDR饋入資料轉換為低位元率、低動態範圍(LDR)影像的智慧化運算處理,過程中還能確保不遺失任何有關汽駕感知的關鍵資訊。

丟資料未必代表丟了重要資訊

IPI團隊的Jan Aelterman教授指出:「色調映射技術出現一段時間了,常用於智慧型手機。不過,若要把這項技術用在車用場景和行人偵測上,就特別需要納入一套全新考量並做出取捨。對於哪些資料需要保留、哪些資料可以在不危及人身性命的前提下丟棄,這些都是問題,這也是我們過去一直在經歷的特殊考驗。」

| 圖五 : 評估愛美科的自動化色調映射技術:根特大學研究人員版本(右圖)以及現有色調映射軟體版本(左圖)。(source:imec) |

|

IPI團隊的研究成果如圖所示,包含了四張由HDR相機拍攝的場景。左圖的兩張影像已透過現有的軟體完成色調映射處理,而右圖成像則運用該團隊研發的卷積神經網路(CNN)色調映射方法。

Aelterman教授進一步說明:「觀察左下方的影像,你會發現車頭燈那邊呈現許多細節,但也因此就看不出其他形狀。然而,在右下方的影像中,車頭燈的細節雖然不見了,但那位行人就被辨識出來了。」

他表示,這就是個證明愛美科自動化色調映射方法潛能的絕佳例證。運用車用資料集,車載系統的神經網路就能進行訓練,尋找可能與車用感知相關的低階影像細節,並丟棄那些被視為不相關的資料。換句話說,雖然丟了部分資料,但所有與弱勢用路人所在位置相關的重要資料都被保留了下來。

Alterman教授更指出:「這套基於神經網路的影像處理方法還有另一項優勢,就是能與其他不同特色功能結合,例如減輕雜訊或是去馬賽克演算法,最終甚至能與去除假影(artefact)的演算法結合,像是起濃霧或下雨等天氣狀況就容易干擾感測器而產生假影。」

無違和地自然顯示色調映射成像

保留影像中攸關性命存亡的資訊是一回事,但如何無違和地自然顯示成像,其重要性也不容小覷。這也是IPI團隊的研究重點。

「一般的色調映射成像通常看起來都很怪,行人可能比太陽還要亮,騎單車的人身邊可能出現光暈,而色調可能被增強到不自然甚至是螢光的程度。」Alterman說道。

他解釋,對AI引擎來說,這些假影無足輕重,但對人類駕駛而言,他們應該也要能夠根據色調映射影像來做出決策。例如,這些影像可以整合到汽車數位後視鏡頭或後照鏡。

準確度提升10%~30%

愛美科的自動化色調映射方法能夠優化成像品質,效果顯而易見,但這能轉換為可量化的效益嗎?

「當然沒問題,」Jan Aelterman說道:「與SDR相機相比,這套方法未偵測到的行人數量大幅下降了30%,這也比其他文獻使用的色調映射技術還提升了10%。或許一開始會覺得這不算什麼,但實際上,每個未被偵測到的行人都面臨了極大的風險。」

Aelterman教授總結:「我們目前正在研究如何將自動化色調映射技術整合到其他的感測器融合研究,畢竟這兩項技術能夠完美互補,打造出超高效的行人偵測系統。」

(本篇由愛美科授權刊登;作者Jan Aelterman1與David Van Hamme2為愛美科於比利時根特大學設置之IPI研究團隊的1教授與2資深研究員;編譯/吳雅婷)