人工智慧(AI)已經開始改變我們生活的許多面向,創造了顯著的社會進步。從自動駕駛汽車到AI輔助醫療診斷,都顯示出我們正處於一個真正變革時代的開端。

然而,既然有了機會,挑戰也隨之而來。AI推論是基於訓練有素的機器學習演算法進行預測的過程,無論是部署在雲端、邊緣還是終端,都要求在嚴格的功率預算(power budget)下提供優異的處理效能。人們普遍認為,僅憑CPU難以滿足這項要求,而是需要某種形式的運算加速才能更有效地處理AI推論的工作負載。

與此同時,AI演算法正快速發展,且比傳統晶片的開發周期更迅速。如果使用ASIC等固定功能的晶片實現AI網路,則可能因先進AI模型的快速創新而很快就被淘汰。

整體應用加速

此外,還有第三個較鮮為人知的挑戰,這項挑戰來自於AI推論無法單獨部署。真正的AI部署通常需要在AI功能之前和之後進行非AI處理;例如,圖像可能需要完成解壓縮和縮放後才能符合AI模型的資料輸入要求。這些傳統的處理功能必須在與AI功能相同的吞吐量(throughput)下運行,並且又要實現高效能與低功耗。與AI推論實現方案一樣,非AI的前處理和後處理功能開始需要某種形式的加速。

僅加速AI是不夠的

要建構真實的應用,就需要高效地執行整體應用。在資料中心應用中,該應用可能擁有數千個至數百萬個並行執行個體(instance)。如果每個執行個體都能節省一定程度的功耗,總功耗將會有顯著下降。

只有當「整體應用」能夠透過加速滿足其效能目標,同時又能藉由提高效率滿足功耗要求時,這樣的解決方案才具備可行性。那麼,我們該如何透過可行的方式實現整體應用加速呢?

這裡有三個關鍵因素:建立自訂資料路徑的能力、使用單一元件執行方案、隨著最新AI模型的不斷發展和演進而充分發揮它的優勢。以下分別具體介紹這三個因素。

建立自訂資料路徑的能力

大部分的AI推論形式是在串流資料上運行。資料通常是動態的,例如影片的其中一部分、正在處理的醫療影像或是正在分析的網路流量。即使將資料儲存在磁碟上,也要從磁碟上讀取資料,並透過「AI應用」進行串流式傳輸。

自訂資料路徑為處理這類資料流提供了最有效的方法。自訂資料路徑讓應用擺脫了傳統的Von-Neuman CPU架構的限制。在這種架構中,資料以小批量從記憶體讀取出,經過處理再寫入回處理器。相反的,自訂資料路徑將資料從一個處理引擎傳遞給下一個處理引擎,不僅延遲時間短且效能適當。過低的處理效能無法滿足這種應用的需求,而過高的處理效能則會降低效率,因?閒置功能會浪費功耗或物理空間。自訂資料路徑提供絕佳的平衡,為應用提供量身定制的執行方案。

單一元件執行方案

有些解決方案非常適合AI推論,但不擅長整體應用處理,如GPU等固定架構元件普遍不適合這類用途。GPU往往能提供很高的TOP(Tera-operations per-second,一種常見的效能指標),但是AI推論效能通常需要與前處理效能和後處理效能匹配。如果非 AI 元件不能在同一個GPU上有效執行,就需要多元件解決方案。藉由要求在元件之間傳遞資料會浪費功耗,因此從功耗的角度來看其效率極低且成本高。因此,一個能夠有效執行整體應用的單一元件在實際AI推論部署中擁有顯著優勢。

靈活適應最新的 AI 模型並隨之演進

AI的創新速度令人歎為觀止。如今被視為先進的AI技術,很可能在半年後就被宣告過時。而使用較舊模型的應用可能會面臨喪失競爭力的風險,所以,能夠快速執行最新模型的能力極為關鍵。

那麼,什麼樣的技術既允許AI模型動態更新,又能提供建立自訂資料路徑的能力,從而在單一元件中加速AI和非AI處理呢?答案是:自行調適運算平台。

自行調適運算平台

自行調適運算平台基於能在製造後動態重配置的硬體上,這包括FPGA等經過長期檢驗的技術,以及賽靈思AI引擎等先進的創新。賽靈思Versal自行調適運算加速平台等單元件平台便於建立自訂資料路徑,加速AI處理和非AI處理功能。此外,因為硬體可以快速重新配置,所以它們也能迅速且有效地執行最新AI模型。自行調適運算元件提供了兩全其美的優勢,既具備自訂ASIC的效率優勢,而無需漫長且高成本的設計週期。

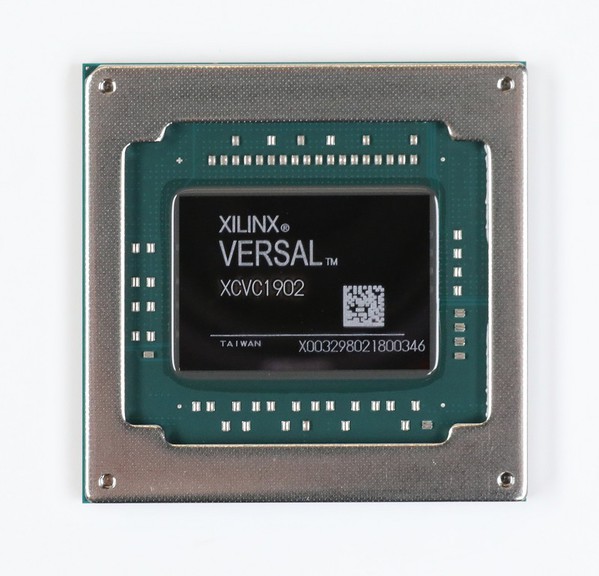

| 圖二 : 賽靈思Versal AI Core系列 VC1902 |

|

最優秀的AI應用執行方案未必是速度最快的。它需要的是在最高效率下,同時保持靈活性。它必須是量身定制且不多不少地提供所需的效能。

總結

隨著AI推論的應用日益普及,其挑戰不僅在於如何部署AI模型,也在於如何最有效地部署整體AI應用。在應用被複製數千次乃至數百萬次時,每個執行個體的少量節能也許能省下整個發電站所需的能源。如果將這種節能擴展到中不計其數開發中的新AI應用中,效果將非常顯著。毫無疑問,整體AI應用的有效加速應成為技術產業所有業者的目標,而自行調適運算平台則提供了極具競爭力的解決方案。

(本文作者Greg Martin為賽靈思策略行銷總監)