全球車市已經從傳統燃油車走向新一代電動車,隨著AI技術日新月異,自駕車也從L1發展到如今的L4,離完全自駕的夢幻境界L5僅一步之遙,只不過,這一步猶如太空人阿姆斯壯登陸月球的那一小步。

汽車逐步邁向高階自動駕駛領域,需要搭配先進的駕駛輔助系統 (ADAS),而不同的自駕需求需要搭配不同的感測器,隨著攝影機、雷達、光達、超音波等感測器越來越「聰明」,負責統整資訊、做出決策、發出執行命令的中控中心也需要具備異質整合的能力,務求最短時間內做出精準判斷,中控中心之於人好比大腦,之於汽車好比感測器融合技術(Sensor Fusion)。

先將鏡頭轉向美國。2018年3月亞利桑那州發生Uber自駕車撞死違規穿越馬路婦人事件,美國國家運輸安全委員會(National Transportation Safety Board)指出:該名女子在沒有斑馬線之處穿越馬路;系統設計沒有將亂穿越馬路的行人納入考量。

事實上,自駕車軟體在撞上女子的6秒前已發現她,但在撞擊前約1.2秒,自駕車軟體卻「選擇」不做「極端的剎車或轉向動作」,以避免車子蛇行,另一方面,自駕車軟體啟動減速計畫時,曾向車上的操控者發出警訊……。如果當時是「人腦」而非「感測器融合技術」做決策、下執行命令,結局會不會不一樣?

答案是「很難說」,人腦真的比較值得信賴?幾個數據值得省思:歐美研究顯示,交通事故中逾9成肇事原因屬於「人為因素」;台灣交通部統計,2020年1-10月全台發生近30萬件交通事故;2016年9月到2018年3月,Uber自駕模式測試車涉及38起事故。行車過程中有太多不可控因素,感知融合技術應用於未來汽車取代人腦一如ADAS逐漸成為汽車「標配」,勢不可避免,然而放手自駕何時才能真正落實?從Uber案例來看,取決於感知融合技術何時能KO人腦。

感測器融合技術在車用市場的發展應用

美國汽車工程師學會(SAE)將自動化程度分為六級,從SAE Leve0無自動化到SAE Level 5全車自動化;Frost & Sullivan預估,2030年自動駕駛將發展至完全自動化(L5)。自駕車要能上路,需要透過攝影機和雷達等感測器「看清楚」路況,也需要運算能力分析判斷各種資料訊息,串連一切的感測器融合技術扮演關鍵角色,實踐過程有相當大的技術挑戰需克服。感測器可分有源感測器和無源感測器,各有優缺點,卻沒有單一感測器可以適用所有路況。因此,自駕車要能到L5完全自駕的地步,需要同時使用多種感測器。

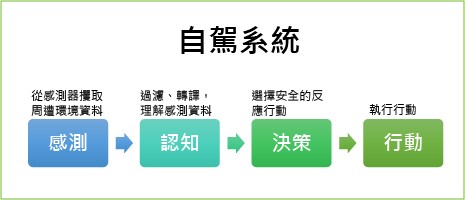

| 圖一 : 自駕系統包含感測、認知、決策與行動等四個關鍵流程。(Source:Arm) |

|

感測器融合(Sensor Fusion)是從不同感測器中取得數據做進一步處理和分析,必要時須要針對終端執行應用進行決策。

工研院資通所嵌入式系統與晶片技術組技術副組長陳澤民指出,不同車場發展自駕車有不同的sensor layout,也會衍生出不同的技術開發,早期Mobileye發展ADAS只有攝影鏡頭,但鏡頭抗天候性不佳,後來雷達、光達出現,「不論是ADAS或自駕車,對感測器的需求重點主要有二:一是抗天候性要強,二是解析度要高,由於行車過程中狀況太多,慢慢有異質感測器強化各種功能,現在還有4D雷達,也進步到AI演算法,未來發展會越來越高階。」比方停車輔助系統加入功能更強大的 CMOS(互補金屬氧化物半導體)感測器,除了將車後影像直接輸出在車內系統螢幕上,也可以進一步成為全自動或半自動停車輔助系統的一部分。

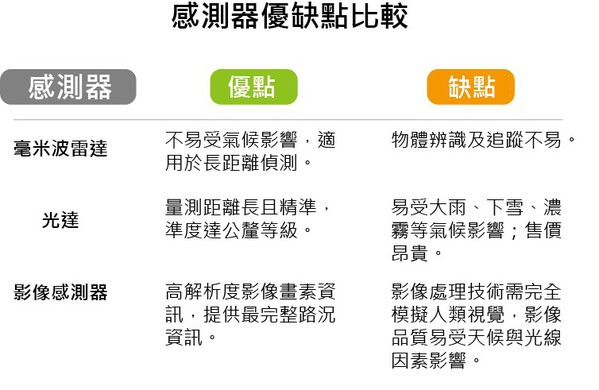

| 圖二 : 感測器優缺點比較。(Source:工研院資通所) |

|

攝影機、雷達、光達、超音波等感測器各有特色,也有不同的盲點,目前還沒有感測器屬於全能型,所以多半是複合式組合,再透過感知融合技術處理不同感測資料,取代人類的視覺、感知與情境,但要完全取代,仍然是個挑戰。

| 圖三 : 工研院資通所嵌入式系統與晶片技術組技術副組長陳澤民。(Source:工研院資通所) |

|

ADAS是利用影像、測距等各式感測器,偵測、辨識與追蹤汽車周遭動、靜態物體,避免錯誤駕駛。陳澤民說,ADAS發展較成熟,商轉高,但只是輔助系統,仍須仰賴人為駕駛,自駕車發展相對不成熟,已達環周物件與道路偵測能力的L3(Eyes off)階段,進入多重感知能力的L4(Mind off)階段。

異中求同的異質感測器融合技術

自駕車必須有解析度高、抗天候性強的感知單元,由於尚未出現多元感測器,必須仰賴異質感測器融合找出最佳解。融合模式可分為三大類,第一類為互補式融合技術(Complementary Fusion Mode),第二類為競爭式融合技術(Competitive Fusion Mode),第三類為合作式融合技術(Cooperative Fusion Mode)。

互補式融合技術模式下,異質感測器的偵測辨識區域不重疊,比方向前看的毫米波雷達與向後看的毫米波雷達各自負責不同的感測區域,有助擴大系統整體感測範圍;競爭式融合技術的異質感測器偵測辨識範圍相同,有利增加系統偵測辨識的可靠度,對於待感測物能提供相同或不同的物理量描述,可強化精確度與完整性。

合作式融合技術的異質感測器偵測辨識範圍重疊,能提供相同或相異的待感測物物理量描述,但是單一感測器除了提供個別資訊外,尚須參考其他感測器提供的資訊,如此有助加速偵測辨識速度並提高正確性,換言之,合作式融合模式下的感測器之間須互相資料傳遞,才能完成偵測辨識能力,完成資料融合。

各感測器偵測辨識物件後產生的偵測結果可能有衝突,必須透過競爭決策融合(Complementary/Competitive Mode)選擇最佳資訊,提供決策與控制單元,最後再由資料融合層(Data Fusion)結合如慣性感測器(IMU)、全球定位系統(GPS)與車聯網(V2X)等非偵測辨識感測器,搭配不同感測器物理量描述進行最優估計(Optimal Estimation),找出精確度與完整性兼備的答案。

合作式融合技術也可稱為特徵融合(Early Fusion),互補式與競爭式融合技術也可稱為平均值融合(Late Fusion),感測器融合(Sensor Fusion)主要以此為主。近期已有研究單位與業者共同開發特徵融合(Early Fusion),如Mentor Graphics開發DRS360自動駕駛集成嵌入式平台,即時集中原始數據融合/深度融合;AEye開發iDAR(Intelligent Detection and Ranging)傳感器,融合LiDAR與低照度Camera,可即時感知周邊動態環境;速騰聚創(Robosense)開發Lidar-Camera-Deep-Fusion技術,可減少感測器資料傳輸延遲,提供更多資訊方便感測器處理數位訊號,除了加強去雜訊能力,也能提高物件偵測辨識能力,大大提高環境感知次系統的執行力。

行車環境不可掌控因素太多,自駕車在L4(高度自駕)邁向L5(完全自駕)的過程中還必須仰賴高可靠度的環境感知能力幫助人類駕駛,深度學習與感測融合的整合開發有助提高自駕辨識能力,如影像前處理可以提升影像品質,強化偵測辨識準確率,比方將大雨環境下的模糊影像降低為小雨模糊化程度;異質感測器原始資料融合有助建立高解析度環境模型,抑制訊號雜訊,加速偵測辨識速度並提升準確率;異質感測器決策融合可依據當下環境條件,計算各感測器偵測辨識信心指數,進而做出最終決策,提高系統準確性與可靠度;事件推斷則有助預測可能發生的危險事件,協助系統在發生危險之前預先執行防範動作。

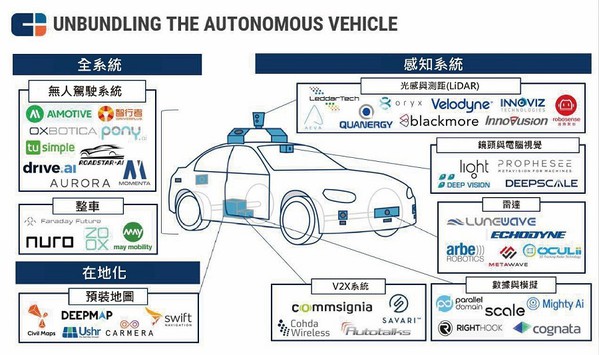

| 圖四 : 自駕車組成要素。(Source:CBINSIGHTS) |

|

自駕車商機無限 2035年全球銷量達25%

陳澤民坦言,要進展到L5等級的商業模式非常困難,實際操作還是以L4為主。非封閉場域周邊有無法預測的變數,設定參數越多越安全,但很難達到零風險,所以L4自駕車上路都會搭配測試員。即便在限定範圍內搭配高精地圖與先進感測技術,2018年仍發生Uber自駕車撞死違規穿越馬路婦人的憾事,可見「放手自駕」真的難。

雖然困難重重,自駕車市場商機無限卻是不爭的事實。波士頓顧問集團BCG預估,2025年自駕車市場產值估計達420億美元,2035年可望佔全球汽車銷量的25%。除了國際大廠Mobileye聚焦Vision-based車用感測解決方案外,國內車用影像感測器業者包含昇銳電子、合盈光電、光寶等,車用感測器IC廠商則是恩智浦(NXP)、英飛凌(Infineon)、意法半導體(STM)、瑞薩電子(Renesas)及德儀(TI)等大廠的天下。

未來自駕車要能真正商轉,技術問題只佔四分之一。KPMG全球總部發佈《2020自動駕駛汽車準備度》報告,計對三十個國家的自駕車準備度進行評估與排名,評估的四項指標是政策法規、科技與創新、基礎建設及消費者接受度,前三名為新加坡、荷蘭與挪威,台灣首次參加名列第13。

自駕車發展龍頭特斯拉汽車(Tesla)目前的發展進度接近L5,國際大廠Alphabet旗下的Waymo正朝L4邁進,至於台灣的自駕車發展,最常見的是L2,2020年出現全台首輛L4無人自駕車WinBus外,經濟部、新竹縣政府、工研院及科技之星、車王電子、銓鼎科技等業者也在2021年啟動自駕電動中巴在竹北市區與高鐵間的接駁服務,成為全台首創市區開放混合道路的實驗測試路線。中巴搭載工研院研發的iRoadsafe車聯網技術,結合路側系統整合通訊、感測器與交通號誌等資訊,是發展公共運輸智慧交通的一大突破。

| 圖五 : 新竹縣高鐵自駕接駁服務測試,未來將實際載客運行的自駕電動巴士。(Source:工研院資通所) |

|

夢幻自駕車的最後一哩

自駕車總有一天會達到「智慧駕駛艙」的夢幻境界,在此之前,還有難題需克服。陳澤民指出,從技術角度看,各sensor有不同的偵測結果,「系統(小腦)要選擇相信誰是個問題,目前是用AI邏輯的方式去做,決策系統定義對錯判斷還有待研發,牽扯到後融合技術的突破。」第二是降低感知延遲時間,從事件發生到運算、做出反應要小於150毫秒,「如何降低整個感知的延遲時間是大家正在努力的,希望感知延遲可以控制在66毫秒內。」第三是即時校正,車輛基座等零件可能鬆脫,定位、距離可能失準,如何讓sensor隨時精準校正會耗費很多computing power。

第四是找資料,自駕車必須短時間內在不同國家或環境都能上路,比方台灣出口自駕中巴到瑞典,必須讓中巴在瑞典跑得跟台灣一樣好,所以要找到瑞典跟台灣環境的共通性,強化弱勢部份(transfer learning),最好只用少部分瑞典資料及多數台灣資料就能讓中巴在最短時間內上線。

他還建議把聽覺感測器、熱感測器(觸覺)納入考量,透過聽覺sensor就能從聲音判斷是否產生危險,及時做出判斷。熱感測器的好處是可以偵測到動物,散發熱感的物件多半是生命體,可以提升安全性。

「自駕車對乘客來說是智慧的移動空間,除了安全性標配,也要考量搭乘舒適度,甚至納入周邊服務。」陳澤民認為,舒適度包含行車過程少急剎、不暈車等,還有乘客要對自駕車產生信任感。以舒適度來說,除了路徑規劃避免山路,異質感測融合及時偵測路況並做出決策反應也有助避免急剎與暈眩,提高舒適度,「透過感測器技術可以做到安全、舒適、好操作,這三點做好做滿,就能產生信任感。」未來還可以將AI等先進技術納入自駕車配備選項,以人性化出發,讓自駕車更全方位滿足乘客移動、工作、休閒娛樂等多元需求。