根據IDC最新研究,2024年在疫情影響逐步趨緩下,終端市場回穩,加上資料中心對人工智慧(AI)訓練與推論的需求帶動記憶體提升,整體應用及庫存水準皆開始正常化,連帶帶動2024第一季整合元件製造(IDM)市場的發展,而其中高頻寬記憶體(HBM)扮演重要角色。

高頻寬記憶體的需求不斷成長,價格比傳統記憶體高出四到五倍,也進一步壓縮到終端市場的DRAM產能促使DRAM價格提升,使得總體記憶體市場營收大幅成長。同時,AI PC以及AI智慧型手機逐步釋出市場,其所需要的記憶體內容較傳統裝置增加,也帶動記憶體整體市場發展。

人工智慧伺服器對運算能力的快速成長,順勢帶動了高頻寬記憶體的需求,為記憶體部門帶來許久未見的成長動能。SEMI指出,爆炸性的AI技術落地風潮需要HBM堆疊配置更加緊密,每個HBM現已可整合8到12個晶粒,這也正是為什麼許多DRAM市場領導廠商正不斷增加 HBM/DRAM領域的投資。DRAM產能2024年和2025年都將出現9%的成長;相較之下,3D NAND市場的復甦較為緩慢, 2024年產能不會上升,2025年則有5%的漲幅。

在邊緣裝置中人工智慧應用興起影響下,主流智慧型手機DRAM容量也將從8GB增至12GB,而配備人工智慧助理的筆記型電腦則有至少16GB DRAM的需求,人工智慧拓展至邊緣裝置可望進一步帶動DRAM需求往上爬升。

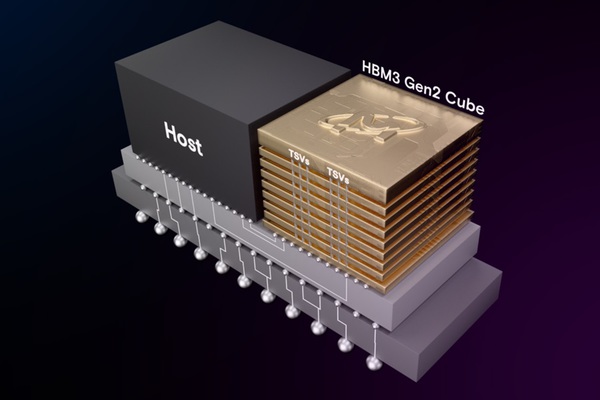

| 圖一 : HBM3 Gen2架構圖(美光科技提供) |

|

HBM

高頻寬記憶體(High Bandwidth Memory;HBM)是一種基於3D堆疊技術的高效能DRAM。它由三星電子、AMD和SK海力士共同開發,目的在滿足高記憶體頻寬需求的應用,如GPU、網路交換裝置等。HBM的設計使其能夠提供比傳統DRAM更高的頻寬和更低的功耗。

HBM透過3D堆疊架構,將多層DRAM晶片垂直堆疊,並使用矽穿孔(TSV)技術進行連接,實現高頻寬和高容量。其頻寬遠高於傳統DRAM,這使得它能夠快速傳輸大量數據。而由於其高效的設計,HBM在提供高性能的同時,能夠保持較低的功耗。

現階段AI模型需要處理大量數據,HBM的高頻寬特性使得數據傳輸速度大幅提升,加快了AI處理器與記憶體之間的通訊速度。另外隨著AI模型(如大語言模型)的參數量增加,對記憶體頻寬和容量的需求也隨之增加。HBM能夠提供足夠的頻寬和容量,支持更大、更複雜的AI模型進行訓練。而HBM的設計縮短了數據路徑,減少了數據傳輸的延遲,這對於需要即時處理數據的AI應用尤為重要。

除了AI伺服器之外,HBM還廣泛應用於高效能運算(HPC)、圖形處理、網路設備等領域。當然隨著AI技術的發展,HBM在AI運算中的地位將變得越來越重要。HBM的3D堆疊技術主要通過以下幾個步驟實現:

矽穿孔技術

矽穿孔(Through-Silicon Via;TSV)是HBM 3D堆疊技術的核心。TSV技術在每層DRAM晶片上鑽出微小的垂直孔,並填充導電材料(如銅),以實現層與層之間的電氣連接。

微凸塊銲錫連接

在每層DRAM晶片的表面,使用微凸塊銲錫(Microbump)技術進行連接。這些微小的銲錫凸塊能夠確保每層晶片之間的穩定電氣連接。

矽中介層

HBM晶片堆疊在一個矽中介層(Silicon Interposer)上,這個中介層負責將HBM與CPU或GPU等核心元件連接起來。矽中介層上有許多細小的導線,能夠實現高頻寬的數據傳輸。

精密對齊與封裝

在堆疊過程中,每層DRAM晶片需要精確對齊,確保TSV和微凸塊能夠正確連接。這需要高度精密的製造技術和設備。

散熱管理

由於多層晶片堆疊會產生大量熱量,因此需要有效的散熱解決方案。通常會在堆疊結構中加入散熱材料或設計特殊的散熱通道,以確保晶片在高效運行時不會過熱。

HBM的3D堆疊技術儘管帶來了高頻寬和低功耗的優勢,但在實現過程中也面臨多項挑戰。其多層DRAM晶片需要高度精準地堆疊在一起,確保每層晶片的對準精度非常高,以避免電氣性能損失。這需要極高的製造技術水準。而TSV技術涉及在每層晶片上鑽出垂直通孔,並在通孔內填充導電材料。這需要精密的刻蝕和填充技術,稍有不慎就可能導致電氣連接或熱應力問題。

另外,HBM的封裝需要將晶片、基板和散熱材料等多種材料整合,並配合各材料的熱膨脹係數,避免熱膨脹差異導致機械應力和晶片損壞。封裝的可靠性也需要確保,包括抗機械衝擊、熱迴圈和電遷移等。

由於HBM是3D堆疊結構,單位體積的熱量密度更高,導致晶片熱量難以散發,可能引發熱失效。需要高效的熱管理方案,如先進的散熱材料和結構設計,以確保晶片的熱穩定性。HBM也需要高頻寬傳輸,對電源分配網路有極高要求,任何雜訊都可能影響HBM性能,導致傳輸錯誤。高速數據傳輸對訊號完整性也是挑戰,需要確保高頻環境中的訊號傳輸完整性。

技術比較

接著來比較幾種不同HBM之間的差異。HBM3的傳輸速度最高可達6.4 Gbps,頻寬可達819 GB/s。每個HBM3模組的容量可達16 GB。HBM3採用了16層堆疊技術,並且使用了先進的2.5D/3D封裝技術。主要應用於AI訓練、圖形處理和高效能運算(HPC)等領域。

HBM3E在頻寬和容量上相較於HBM3有顯著提升。它能提供高達1280 GB/s的頻寬,並且單顆記憶體的容量可達36 GB。HBM3E也採用了更先進的製程技術和封裝技術,這使得它在性能和能效方面都有所提升。在應用場景方面,HBM3E主要應用於AI伺服器、高效能運算(HPC)和自駕車等領域。

HBM4是新一代的HBM記憶體,預計將在2026年推出,頻寬將達到2048位元,這將使其頻寬和容量大幅提升。HBM4將採用16層堆疊技術,並使用12奈米邏輯製程技術,這將使其在性能和能效方面有顯著提升。此外,HBM4也採用了新的混合鍵合技術,同時保持記憶體堆疊的完整性。HBM4將主要應用於未來的AI處理器和高效能運算市場,並且將更注重定制化需求。

主要技術發開商

目前,主要發展HBM(高頻寬記憶體)的廠商包括SK海力士、三星電子,以及美光科技。在2023年,SK海力士的市場佔有率超過50%,是HBM市場的領導者。三星電子也是HBM技術的重要參與者,積極擴產以追趕市場需求。美光科技在HBM市場中也佔有一席之地,並且依靠技術優勢來爭取更多市場份額。這些廠商不僅在傳統DRAM記憶體市場中占有重要地位,目前也積極投入研發最新的HBM技術及量產。

美光科技

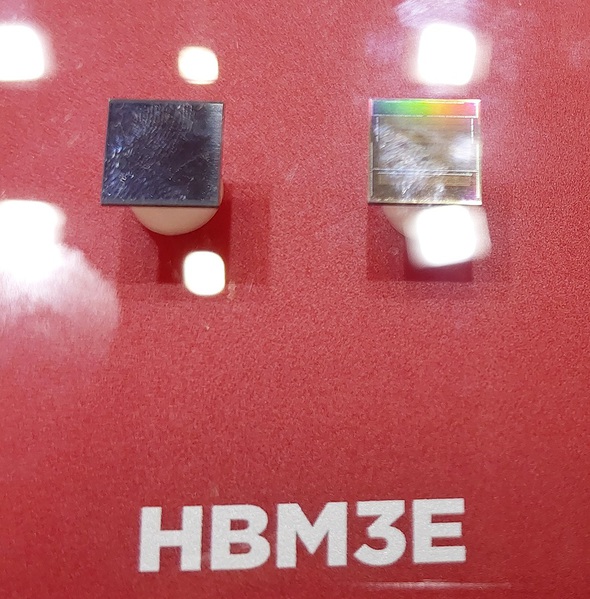

| 圖二 : Sk Hynix最新的HBM3E記憶體晶片。 |

|

美光科技在HBM(高頻寬記憶體)領域的技術進展方面,目前美光的HBM3E記憶體採用了8層和12層堆疊技術,這些記憶體晶片基於1β(1-beta)技術,能夠在更小的尺寸內提供24GB或36GB的容量。HBM3E的記憶體頻寬超過1.2 TB/s,Pin速度超過9.2 Gb/s,功耗比競爭對手低30%。這得益於先進的CMOS技術和多達2倍的TSV(矽穿孔)技術。

在應用上,HBM3E記憶體特別適合用於AI加速器和高效能運算(HPC)系統,能夠縮短大型語言模型(LLM)的訓練時間,並支援更大的模型。美光也透過先進封裝技術改善了熱阻抗,提升了散熱效能,並且在每個記憶體實例8Gbps的速度下,功耗降低了30%。美光也正計劃在2025年挑戰HBM市場25%的市佔率,並且正在開發新一代的HBM4產品。美光的HBM技術不僅在效能和功耗方面具有優勢,還在AI和高效能運算領域中發揮了重要作用。

SK海力士

SK海力士在HBM技術方面有多項重要進展。目前SK海力士正在加速開發混合鍵合技術(Hybrid Bonding),這種技術能夠在不使用微凸塊的情況下連接DRAM模組,大幅降低晶片厚度,並提高製程可靠性。這項技術已在HBM2E中通過所有可靠性測試,並計劃應用於未來的HBM4產品。

SK海力士也正與台積電合作,開發客製化的HBM解決方案,以滿足不同客戶的效能和省電需求。這種客製化策略有助於解決記憶體市場供過於求的問題,並確保產品能夠更符合客戶需求。

SK海力士在HBM3E中也導入了MR-MUF(Mass Reflow Molded Underfill)製程,這種技術提高了產品的散熱效能和可靠性。此外,SK海力士還計劃在HBM4中使用與台積電合作的先進製程,以進一步提升性能和能源效率。SK海力士預計在2026年量產HBM4,並計劃在2027年提前量產HBM4E,以應對市場需求的快速變化。

三星電子

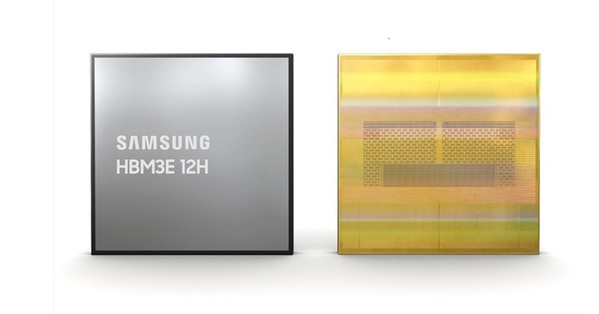

| 圖三 : 三星已宣布完成12-Hi 36GB HBM3E記憶體堆疊的開發 |

|

三星電子在HBM方面,目前正採用熱壓縮非導電薄膜(TC-NCF)技術,這種技術具有抗彎曲特性,能夠製造更多層的DRAM堆疊,提高記憶體的容量和效能。三星也擁有自己的晶圓代工廠,這使得他們能夠在HBM的最底層控制晶片上使用自家技術,提高產品的一致性和性能。

三星成功開發了業界首款整合AI處理能力的高頻寬記憶體(HBM-PIM),這種記憶體處理(processing-in-memory;PIM)是一種在記憶體內整合AI運算的記憶體晶片架構,賦予高效能記憶體AI運算能力,可加速資料中心大規模數據運作和高效能運算(HPC)系統。三星也正在開發混合鍵合技術,這種技術能夠焊接更多晶片堆疊,維持更低的堆疊高度並提高熱排放效率,這對於未來的HBM4和更高代產品尤為重要。三星也計劃在2025年提供HBM4樣品,並在2026年量產,這顯示出他們在市場上的積極佈局和對未來技術的投入。

結語

| 圖四 : HBM不斷進步,每一代都在頻寬、容量和能效方面有所提升。 |

|

高頻寬記憶體非常有未來發展性,特別是在人工智慧和高效能運算領域。隨著生成式AI和大語言模型(LLM)的快速發展,對高頻寬記憶體的需求也在增加。HBM能夠提供更高的頻寬和更大的容量,有助於處理大量數據和複雜計算。HBM技術正不斷進步,從HBM2到HBM3,再到即將推出的HBM3E和HBM4,每一代都在頻寬、容量和能效方面有所提升。

主要的記憶體製造商如SK海力士、三星和美光正在積極擴展HBM的產能,以滿足市場需求。這些公司也在技術上不斷創新,以保持競爭優勢。HBM的市場需求預計將持續成長。

根據預測,HBM的年複合成長率(CAGR)將達到50%,特別是在AI伺服器和自駕車市場。除了AI伺服器,自駕車、5G網路設備和高效能運算也是HBM的重要應用場景。這些應用需要高頻寬和低延遲的記憶體來支持其運行。放眼未來,HBM技術的未來發展前景非常樂觀,隨著技術的進步和市場需求增加,HBM將在更多領域中發揮重要作用。