英特爾在2023年國際超級電腦大會(ISC High Performance)上,展示高效能運算(HPC)和人工智慧(AI)工作負載的領先效能,並分享以oneAPI開放式程式設計模型為中心的未來HPC和AI產品;同時也宣布一項國際計畫,利用Aurora超級電腦為科學和社會開發生成式AI模型。

|

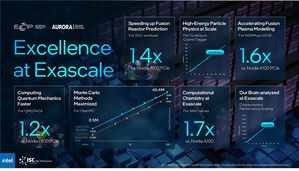

| 英特爾極具競爭力的效能成果。(圖片來源:英特爾公司) |

英特爾公司副總裁暨超級運算事業部總經理Jeff McVeigh表示:「英特爾致力為HPC和AI社群提供產品服務,協助客戶和終端使用者能夠更快達成突破性的發展。我們的產品組合橫跨Intel Xeon CPU Max系列、Intel Data Center GPU Max系列、第4代Intel Xeon可擴充處理器和 Habana Gaudi 2,於多項工作負載表現均優於競爭對手,提供能源和總擁有成本優勢,讓AI民主化的同時,還提供選擇性、開放性和靈活性。」

大規模硬體效能提升

在英特爾的特別演說中,McVeigh聚焦於橫跨硬體範疇的最新、具競爭力的效能結果,並與客戶分享強勁的態勢。

此外,英國劍橋大學的Cambridge Open Zettascale實驗室已在英國部署首個Max GPU測試平台,並於分子動力學和生物成像應用方面看到正向的早期成果。日本理化學研究所(RIKEN)也宣布與英特爾簽屬合作備忘錄(MOU),將專注於AI、HPC和量子運算等先進運算技術領域,加速聯合研究與開發。作為合作備忘錄的其中一項內容,理化學研究所還將與英特爾晶圓代工服務合作,打造這些全新解決方案的原型。

為各項工作負載提供具有競爭力的處理器

動態、新興的HPC和AI工作負載需要一個完整的硬體與軟體解決方案產品組合。McVeigh綜述英特爾的各項資料中心產品,這些產品為HPC社群提供許多選擇和解決方案,協助實現AI民主化。

McVeigh在演說中介紹英特爾的次世代處理器,將能夠滿足高記憶體頻寬需求。英特爾所引領的生態系為Granite Rapids開發一款新型DIMM-Multiplexer Combined Ranks(MCR)。MCR在DDR5的基礎上達成8,800MT/s速度,在雙插槽系統中實現大於1.5TB/s的記憶體頻寬能力。提升此類的記憶體頻寬,對於滿足現代CPU快速成長的核心數量,以及實現效率和靈活性而言十分重要。

英特爾還公開Supermicro推出的新款、針對AI最佳化的x8 Max系列GPU子系統,專為加速深度學習訓練而設計。除了今年稍晚可透過IntelR Developer Cloud beta使用該系統之外5,多家OEM將提供包含Max系列GPU x4和x8 OAM子系統和PCIe卡的解決方案,這些解決方案預計於今夏上市。

英特爾的次世代Max系列GPU-Falcon Shores,能夠為客戶提供靈活性,實現系統級的CPU和獨立GPU組合,以因應未來新興且快速變化的工作負載。

用於科學領域的生成式AI

美國阿貢國家實驗室與英特爾和HPE合作,宣布計畫為科學研究社群建立一系列生成式AI模型。

美國阿貢國家實驗室副實驗室主任Rick Stevens表示:「該計畫旨在充分汲取Aurora超級電腦的全部潛力,藉此產出可用於能源部實驗室以及與其它單位合作,以便進行後續科學研究的資源。」

這些用於科學的生成式AI模型,將使用一般文字、程式碼、科學文本,以及來自生物學、化學、材料科學、物理學、醫學和其它來源的結構化科學資料進行訓練。

由此產生的模型(多達1兆個參數)將被用在各式各樣的科學應用,其中包含分子和材料設計,並從數百萬個來源綜合知識,提出系統生物學、高分子化學與能源材料、氣候科學、宇宙學等領域的新奇實驗。該模型還會用於加速辨識癌症和其它疾病有關的生物過程(biological process),並提出藥物設計目標。

阿貢實驗室正在帶領國際合作、推進計畫,合作夥伴包含英特爾、HPE、美國能源部實驗室、美國與國際間的大學、非營利組織以及日本理化學研究所等國際合作夥伴。

oneAPI實現高生產力、開放的加速運算

全球約有90%的開發者,使用或是受益於為英特爾開發或最佳化的軟體。自2020年推出oneAPI程式設計模型以來,開發者已在來自多個硬體供應商,不同的CPU、GPU、FPGA和AI晶片上展示oneAPI,解決單一供應商把持加速程式設計模型的挑戰。最新的Intel oneAPI透過OpenMP GPU卸載進而加速HPC應用,延伸支援OpenMP和Fortran,並透過最佳化框架來加速AI深度學習,包含TensorFlow、PyTorch以及相關AI工具,讓效能獲得數個量級的提升。

為了讓程式設計師更容易開發oneAPI多架構程式,oneAPI實作SYCL,並由Codeplay開發針對NVIDIA和AMD處理器的外掛程式,以及Intel DPC++相容性工具(使用開放原始碼SYCLomatic);這款工具可以將CUDA轉換至SYCL和C++,一般而言可自動轉換90%~95%程式碼。7透過這種方式產生的SYCL程式碼,可比擬在NVIDIA和AMD原生系統語言上執行相同程式碼的效能。資料顯示,於Max系列GPU執行DPEcho天文物理學應用SYCL程式碼,其效能相較在NVIDIA H100執行同樣的CUDA程式碼更高出48%。

擁抱SYCL的生態系正在蓬勃發展。Atos旗下的Eviden宣布與英特爾合作推出CEPP one+,這是一款使用Eviden卓越效能程式設計中心(CEPP)的HPC∕AI程式碼現代化服務。CEPP one+將專注接納SYCL和OpenMP,為社群做好異質運算環境的準備,同時透過開放標準提供硬體選擇的自由。